O cenário de cibersegurança da indústria blockchain foi abalado por um novo estudo que soa como um alerta urgente para desenvolvedores e investidores. A pesquisa, divulgada pela empresa de segurança de IA ANTHROPIC, em colaboração com o grupo MACHINE LEARNING ALIGNMENT & THEORY SCHOLARS (MATS), revela uma nova e alarmante realidade: agentes de inteligência artificial agora são capazes de identificar e explorar vulnerabilidades complexas em contratos inteligentes de forma autônoma e com uma eficiência assustadora.

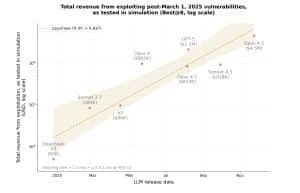

De acordo com o estudo, os modelos comerciais de IA atuais — especificamente o CLAUDE OPUS 4.5 e o CLAUDE SONNET 4.5 da ANTHROPIC, e o GPT-5 da OPENAI — desenvolveram, em conjunto, exploits para contratos inteligentes avaliados em cerca de US$ 4,6 milhões. Esse valor foi gerado testando os modelos em contratos implantados após a coleta dos dados de treinamento mais recentes dos modelos, comprovando que as IAs não estavam simplesmente reproduzindo hacks conhecidos de seus conjuntos de treinamento, mas descobrindo ativamente falhas no código que nunca haviam visto antes.

A equipe de pesquisa, atuando como uma “equipe vermelha” para testar a resistência desses sistemas, utilizou um benchmark recém-desenvolvido chamado SCONE (Exploração de Contratos Inteligentes). Este conjunto de dados compreende 405 contratos reais que sofreram explorações entre 2020 e 2025. Quando aplicados a esse conjunto histórico de vulnerabilidades, 10 modelos de IA distintos geraram com sucesso exploits prontos para uso em 207 dos contratos, resultando em um roubo simulado de US$ 550,1 milhões. Essa taxa de sucesso sinaliza uma mudança crucial na “corrida armamentista” entre segurança digital e roubo automatizado.

Talvez a descoberta mais alarmante tenha sido a de vulnerabilidades “zero-day” — falhas desconhecidas pelos desenvolvedores do software e para as quais não existe correção. Quando os pesquisadores utilizaram o CLAUDE SONNET 4.5 e o GPT-5 em 2.849 contratos recentemente implantados na BINANCE SMART CHAIN (BSC) que eram considerados seguros, os agentes descobriram, de forma independente, duas novas vulnerabilidades zero-day. Em seguida, eles produziram exploits funcionais avaliados em US$ 3.694. Crucialmente, o custo para gerar esses ataques por meio da API do GPT-5 foi de aproximadamente US$ 3.476, o que significa que o ataque não era apenas tecnicamente viável, mas também imediatamente lucrativo.

“Isso demonstra, como prova de conceito, que a exploração autônoma lucrativa no mundo real é tecnicamente viável. Uma descoberta que reforça a necessidade da adoção proativa de IA para defesa.”

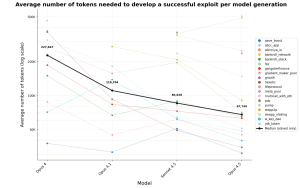

A economia do cibercrime está mudando rapidamente a favor do atacante. O estudo destaca um aumento drástico na eficiência, observando que a “saída necessária” (medida em tokens) para um agente de IA criar um exploit bem-sucedido está despencando.

“Analisando quatro gerações de modelos CLAUDE, o número mediano de tokens necessários para produzir um exploit bem-sucedido diminuiu 70,2%.”

afirma o relatório. Em termos práticos, isso significa que o “custo operacional” para um potencial hacker equipado com IA está caindo drasticamente, enquanto suas ferramentas se tornam mais sofisticadas. O custo médio para realizar uma varredura exaustiva em um contrato em busca de vulnerabilidades caiu para um valor irrisório de US$ 1,22.

Esse ganho de eficiência é impulsionado pelo que os especialistas chamam de “loops de agentes”. Ao contrário dos simples analisadores de código do passado, os agentes de IA modernos conseguem planejar, raciocinar e executar estratégias de múltiplas etapas. Eles não apenas identificam um erro de sintaxe; compreendem a lógica do contrato e podem elaborar interações complexas para drenar fundos. O estudo observa que, em apenas um ano, os agentes de IA saltaram de explorar apenas 2% das vulnerabilidades no cenário pós-março de 2025 para impressionantes 55,88%.

As implicações para o setor de finanças descentralizadas (DeFi) são profundas. Historicamente, havia um “período de tolerância” entre a implantação de um contrato vulnerável e sua exploração, dando aos hackers éticos ou desenvolvedores uma janela estreita para identificar e corrigir as falhas. Os pesquisadores da ANTHROPIC alertam que

“A janela entre a implantação de um contrato vulnerável e sua exploração continuará a diminuir.”

Num cenário num futuro próximo, um agente de IA poderia analisar cada novo contrato no instante em que este chega ao mempool, identificar uma falha e executar uma transação de exploração no mesmo bloco, deixando os defensores humanos literalmente sem tempo para reagir.

Para combater essa ameaça, a indústria precisa mudar de uma abordagem reativa de aplicação de patches para uma defesa proativa com IA. As mesmas capacidades “agentes” usadas para invadir contratos devem ser integradas ao pipeline de desenvolvimento, usando IA para auditar o código em tempo real antes mesmo de sua implantação. Como conclui o relatório, a era das auditorias de segurança exclusivamente humanas chegou ao fim; num mundo onde os atacantes de silício nunca dormem, a única defesa viável são sentinelas de silício igualmente implacáveis.