Virginia Tech, uma universidade nos Estados Unidos, publicou um relatório que descreve potenciais preconceitos na ferramenta de inteligência artificial (IA) ChatGPT, sugerindo variações nos seus resultados sobre questões de justiça ambiental em diferentes condados.

No relatório, pesquisadores da Virginia Tech alegaram que o ChatGPT tem limitações no fornecimento de informações específicas de áreas sobre questões de justiça ambiental.

No entanto, o estudo identificou uma tendência que indica que a informação estava mais facilmente disponível para os estados maiores e densamente povoados.

“Em estados com populações urbanas maiores, como Delaware ou Califórnia, menos de 1% da população vivia em condados que não podem receber informações específicas.”

Entretanto, as regiões com populações mais pequenas não tinham acesso equivalente.

“Em estados rurais como Idaho e New Hampshire, mais de 90% da população vivia em condados que não podiam receber informações locais específicas.”

Citou ainda um professor chamado Kim, do Departamento de Geografia da Virginia Tech, pedindo mais pesquisas à medida que preconceitos vão sendo descobertos.

“Embora sejam necessários mais estudos, nossas descobertas revelam que existem atualmente preconceitos geográficos no modelo ChatGPT.”

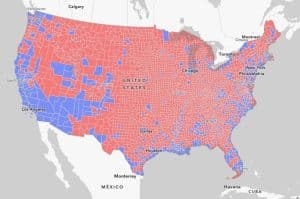

O documento de pesquisa também incluiu um mapa que ilustra a extensão da população dos EUA sem acesso a informações específicas do local sobre questões de justiça ambiental.

Isto segue notícias recentes de que estudiosos estão descobrindo possíveis preconceitos políticos exibidos pelo ChatGPT nos últimos tempos.

Em agosto de 2023, pesquisadores do Reino Unido e do Brasil publicaram um estudo que declarava que grandes modelos de linguagem, como o ChatGPT, produziam textos contendo erros e preconceitos que poderiam enganar os leitores.