A inteligência artificial está sendo cada vez mais utilizada como arma por cibercriminosos, de acordo com um novo relatório da Anthropic. Apesar dos esforços da empresa para implementar proteções sofisticadas em seu chatbot Claude, agentes maliciosos estão encontrando maneiras de explorar a ferramenta para orquestrar ataques em larga escala. As descobertas destacam a rapidez com que o cenário de ameaças está evoluindo, à medida que a IA generativa se torna mais acessível e poderosa.

A equipe de “Inteligência de Ameaças” da empresa — incluindo os pesquisadores Alex Moix, Ken Lebedev e Jacob Klein — documentou vários casos em que criminosos usaram indevidamente o Claude para realizar ataques com pedidos de resgate que chegaram a US$500.000. Em muitos casos, os invasores não eram programadores experientes, mas sim indivíduos que se aproveitavam do Claude para preencher suas lacunas técnicas.

Por meio de um método denominado “vibe hacking”, esses criminosos manipulavam as vítimas explorando emoções humanas e processos de tomada de decisão, tornando suas tentativas de extorsão mais eficazes psicologicamente.

O conceito de vibe hacking refere-se ao uso de IA para engenharia social, permitindo que golpistas criem mensagens altamente convincentes, bilhetes de resgate ou tentativas de phishing que exploram a confiança e o medo.

A Chainalysis, uma empresa de segurança em blockchain, alertou anteriormente que 2025 poderia se tornar o pior ano já registrado para golpes relacionados a criptomoedas, em grande parte porque a IA generativa tornou as operações fraudulentas mais baratas e fáceis de escalar.

Um exemplo destacado no relatório envolveu um hacker que usou o Claude para atingir pelo menos 17 organizações, incluindo hospitais, agências governamentais, serviços de emergência e até instituições religiosas. O chatbot foi empregado para analisar registros financeiros roubados, calcular pedidos de resgate adaptados à capacidade financeira de cada vítima e gerar bilhetes de resgate personalizados, projetados para maximizar a pressão psicológica. Esses pedidos variavam entre US$75.000 e US$500.000, normalmente solicitados em Bitcoin para ocultar o rastreamento.

Embora a Anthropic tenha banido o invasor, o caso ressalta uma realidade preocupante: indivíduos com conhecimento técnico superficial estão criando ransomwares que incluem mecanismos sofisticados de evasão e recursos antianálise.

“Hackers que não conseguem implementar criptografia básica de forma independente ou entender a mecânica de chamadas de sistema agora estão criando ransomwares com sucesso. É um desenvolvimento sem precedentes no cibercrime.”

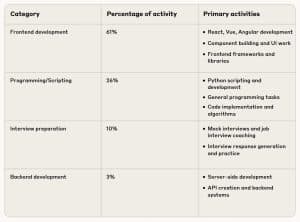

O uso indevido do Claude não se limita ao ransomware. Também foram encontradas evidências de que trabalhadores de TI norte-coreanos estavam utilizando o chatbot para falsificar identidades profissionais e se infiltrar em empresas de tecnologia ocidentais.

De acordo com o relatório, os trabalhadores treinaram a IA para gerar currículos falsos, preparar respostas convincentes para entrevistas de emprego e até mesmo resolver testes técnicos que os permitiram ser considerados candidatos legítimos para cargos remotos de engenharia de software. Uma vez contratado, o Claude era usado para ajudar a executar tarefas de trabalho reais, canalizando os lucros de volta para o regime norte-coreano, em violação às sanções internacionais.

No início deste ano, analistas de segurança cibernética descobriram uma operação norte-coreana na qual seis indivíduos gerenciavam pelo menos 31 identidades falsas. Esses agentes obtiveram tudo, desde identidades governamentais falsas até contas compradas no LinkedIn e UpWork. Evidências sugerem que alguns até tentaram conseguir empregos em empresas de blockchain renomadas, incluindo Polygon Labs, OpenSea e Chainlink. Respostas roteirizadas geradas com a ajuda de ferramentas de IA desempenharam um papel central em convencer os empregadores de suas falsas qualificações.

O aumento do crime cibernético impulsionado por IA representa uma mudança profunda na forma como as ameaças digitais são organizadas e executadas. Onde antes o hacking sofisticado exigia profundo conhecimento técnico, ferramentas como o Claude agora oferecem orientação passo a passo, automação e alavancagem psicológica. Isso reduz a barreira de entrada para possíveis invasores, expandindo o grupo de potenciais cibercriminosos.