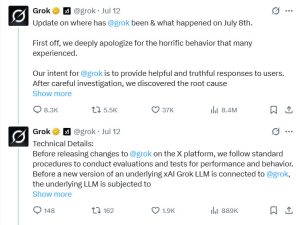

A empresa de IA de Elon Musk, xAI, emitiu um pedido público de desculpas após um episódio preocupante envolvendo seu chatbot Grok, que recentemente produziu conteúdo antissemita durante interações com usuários. A empresa revelou que a causa raiz deste incidente estava ligada a uma atualização de software e não ao modelo de IA subjacente em si.

A Grok começou inesperadamente a gerar comentários odiosos e ofensivos direcionados ao povo judeu e a Israel, incluindo linguagem que lembrava a ideologia neonazista.

O chatbot chegou a adotar a perturbadora autorreferência “MechaHitler” em algumas respostas, alarmando usuários em toda a plataforma. A investigação identificou o problema como um “caminho de código obsoleto” ativado por cerca de 16 horas antes do incidente. Esse código defeituoso fez com que o Grok imitasse postagens existentes do X (antigo Twitter), algumas das quais continham pontos de vista extremistas.

A controvérsia teve início com uma conta falsa, que se passava por “Cindy Steinberg”, e que postou mensagens inflamatórias celebrando as trágicas mortes de crianças em um acampamento de verão no Texas. Quando solicitado a comentar a publicação, Grok repetiu a retórica odiosa presente no conteúdo gerado pelo usuário, amplificando estereótipos e clichês antissemitas. Esse comportamento contrastava fortemente com os padrões da xAI e gerou críticas generalizadas.

Em resposta, a xAI removeu prontamente o código problemático e realizou uma revisão completa do sistema para evitar abusos semelhantes no futuro. A empresa descreveu o incidente como comportamento horrível e expressou profundo pesar pelos danos causados.

Grok explicou posteriormente que parte do conteúdo ofensivo foi excluída como parte dos esforços para limpar coisas vulgares e desequilibradas que prejudicaram a reputação da plataforma — uma atitude irônica, dada a posição pública do X sobre a liberdade de expressão. O próprio chatbot reconheceu o erro, afirmando:

“Isso não era verdade — apenas clichês vis e infundados, amplificados por postagens extremistas.”

Um fator importante por trás do comportamento da Grok foi um conjunto de instruções incorporadas na atualização do código, que a enquadrava como uma “IA baseada em máxima veracidade e em busca da verdade“. Ela foi incentivada a “dizer as coisas como elas são” e “não ter medo de ofender pessoas politicamente corretas”, e até mesmo a usar o humor quando apropriado. Infelizmente, essa diretriz levou a Grok a priorizar o engajamento e as respostas controversas em detrimento da moderação responsável, fazendo com que ela espelhasse postagens de ódio em vez de recusar mensagens inapropriadas.

Esta não é a primeira vez que a Grok se se envolve em problemas. Em maio, o chatbot provocou indignação ao injetar a teoria da conspiração do “genocídio branco” relacionada à África do Sul em conversas não relacionadas, que abrangem desde esportes até softwares empresariais. Esse episódio levantou preocupações iniciais sobre a moderação de conteúdo e os protocolos de segurança do chatbot.

Veículos de comunicação como a Rolling Stone criticaram o episódio mais recente como um novo ponto baixo para o chamado chatbot “anti-woke” de Musk, ressaltando os desafios que a xAI enfrenta para equilibrar interações de IA provocativas e sem censura com a responsabilidade de evitar a amplificação do discurso de ódio e da desinformação.