Apesar do recente entusiasmo com os avanços em inteligência artificial, pesquisadores da Apple alertam que os principais sistemas de IA atuais permanecem significativamente limitados em suas capacidades de raciocínio, ficando muito aquém do tão almejado objetivo da inteligência artificial geral (AGI).

Em um artigo publicado em junho, intitulado “A Ilusão do Pensamento”, a equipe de aprendizado de máquina da Apple apresenta uma análise crítica dos modelos de linguagem de ponta (LLMs), revelando lacunas fundamentais em sua capacidade de raciocínio consistente e generalizável.

A inteligência geral artificial — frequentemente descrita como uma IA capaz de compreender, aprender e aplicar conhecimento de forma tão flexível e robusta quanto um ser humano — é considerada o “Santo Graal” da pesquisa em IA. Muitos líderes do setor expressaram otimismo de que a AGI possa chegar em poucos anos.

Por exemplo, o CEO da OpenAI, Sam Altman, afirmou no início deste ano que sua organização está mais perto do que nunca de criar a AGI, afirmando confiança em seu roteiro técnico. Da mesma forma, o CEO da Anthropic, Dario Amodei, previu que a IA avançada (AGI) poderia superar as capacidades cognitivas humanas até 2026 ou 2027.

No entanto, as descobertas dos pesquisadores da Apple servem como um lembrete preocupante de que os modelos atuais de IA permanecem fundamentalmente limitados. Embora iterações recentes de modelos de linguagem de grande porte, como o ChatGPT da OpenAI e o Claude da Anthropic, tenham incorporado “modelos de raciocínio de grande porte” (LRMs) mais avançados, suas habilidades reais de raciocínio ainda são pouco compreendidas e surpreendentemente frágeis.

A maioria das avaliações contemporâneas de IA enfatiza a precisão em benchmarks bem estabelecidos, particularmente em áreas como matemática e programação de computadores. No entanto, a equipe da Apple argumenta que tais métricas se concentram muito estritamente nas respostas finais e não revelam o quão bem os modelos realmente raciocinam em relação aos problemas.

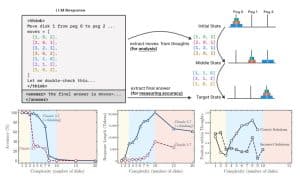

Para investigar mais profundamente as capacidades de raciocínio da IA, os pesquisadores desenvolveram um conjunto de novos jogos de quebra-cabeça projetados para distinguir o raciocínio genuíno da mera correspondência de padrões ou memorização. Esses quebra-cabeças testaram diversos modelos de IA, incluindo diferentes versões do Claude, o3-mini e o1 da OpenAI e os chatbots DeepSeek-R1 e V3.

Os resultados foram impressionantes: quando os problemas ultrapassaram um determinado limite de complexidade, todos os modelos avaliados apresentaram um declínio acentuado na precisão.

Esse “colapso de precisão” sugeriu que esses modelos têm dificuldade para generalizar estratégias de raciocínio quando confrontados com desafios novos ou complexos, contradizendo a ideia de que estão se aproximando da flexibilidade cognitiva de nível AGI.

Um dos principais insights do estudo é que os modelos de IA atuais não desenvolvem internamente ou não compreendem genuinamente os processos de raciocínio. Em vez disso, eles imitam padrões de raciocínio que observaram em seus dados de treinamento — essencialmente gerando sequências lógicas plausíveis sem realmente internalizar os princípios por trás delas.

Os pesquisadores observaram vários comportamentos intrigantes: os modelos de IA frequentemente davam a resposta correta no início de seu raciocínio, mas depois “pensavam demais” no problema, produzindo explicações posteriores falhas ou inconsistentes. Além disso, os modelos apresentaram dificuldades com cálculos exatos e falharam em aplicar algoritmos explícitos de forma confiável em diferentes quebra-cabeças.

Esse raciocínio superficial e inconsistente contrasta fortemente com o tipo de resolução de problemas flexível e generalizável esperado de uma IA. Em outras palavras, apesar do desempenho impressionante em nível superficial, esses modelos ainda estão aquém da compreensão real.

O artigo da Apple sugere que essas descobertas apontam para limitações mais profundas e fundamentais na arquitetura atual e nas abordagens de treinamento usadas para LRMs. A incapacidade desses modelos de manter um raciocínio consistente e escalável em níveis crescentes de complexidade levanta questões sobre o quão próximas as tecnologias existentes realmente estão da IA.

Sua conclusão desafia uma narrativa comum nos círculos de desenvolvimento de IA de que o caminho para a IA é simplesmente uma questão de escala e poder computacional crescentes. Em vez disso, eles argumentam que estruturas ou paradigmas inteiramente novos podem ser necessários para superar as barreiras que atualmente impedem o progresso em direção à inteligência genuinamente geral.