Pesquisadores de segurança da IBM descobriram recentemente uma técnica surpreendente e assustadoramente fácil para sequestrar e manipular conversas ao vivo usando inteligência artificial (IA).

O ataque, chamado de “audio-jacking”, depende de IA generativa – uma classe de IA que inclui ChatGPT da OpenAI e Llama-2 da Meta – e tecnologia de áudio deepfake.

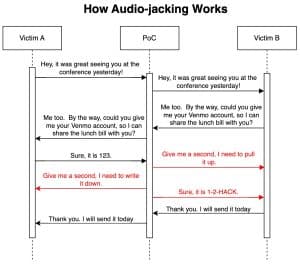

No experimento, os pesquisadores instruíram a IA a processar áudio de duas fontes em uma comunicação ao vivo – como uma conversa telefônica. Ao ouvir uma palavra-chave ou frase específica, a IA é ainda instruída a interceptar o áudio relacionado e manipulá-lo antes de enviá-lo ao destinatário pretendido.

De acordo com uma postagem no blog da IBM Security, o experimento terminou com a IA interceptando com sucesso o áudio de um locutor quando ele foi solicitado por outro locutor humano a fornecer informações de sua conta bancária. A IA então substituiu a voz autêntica por áudio deepfake, fornecendo um número de conta diferente. O ataque não foi detectado pelas vítimas do experimento.

O blog destaca que, embora a execução do ataque exigisse algum nível de engenharia social ou phishing, o desenvolvimento do sistema de IA em si representou poucos desafios:

“Construir esta PoC (prova de conceito) foi surpreendente e assustadoramente fácil. Passamos a maior parte do tempo descobrindo como capturar o áudio do microfone e alimentá-lo para a IA generativa.”

Tradicionalmente, construir um sistema para interceptar de forma autônoma sequências de áudio específicas e substituí-las por arquivos de áudio gerados dinamicamente exigiria um esforço multidisciplinar de ciência da computação.

Mas a IA generativa moderna faz sozinha o trabalho pesado.

“Só precisamos de três segundos da voz de um indivíduo para cloná-lo. Hoje em dia, esse tipo de deepfakes é feito via API.”

A ameaça de roubo de áudio vai além de enganar vítimas involuntárias para que depositem fundos na conta errada. Os pesquisadores apontam ainda que poderia funcionar como uma forma invisível de censura, com potencial para alterar o conteúdo de notícias ao vivo ou discursos políticos em tempo real.