A gigante da mídia social, Meta, apresentou seus mais recentes modelos de inteligência artificial (IA) para edição e geração de conteúdo, de acordo com uma postagem no blog.

A empresa está introduzindo dois modelos generativos alimentados por IA. O primeiro, Emu Video, aproveita o modelo Emu anterior do Meta e é capaz de gerar videoclipes com base em entradas de texto e imagem. O segundo modelo, Emu Edit, é focado na manipulação de imagens, prometendo mais precisão na edição de imagens.

Os modelos ainda estão em fase de pesquisa, mas Meta afirma que seus resultados iniciais mostram casos de uso potenciais para criadores, artistas e animadores.

De acordo com a postagem do blog Meta, o Emu Video foi treinado com uma abordagem fatorada, dividindo o processo de treinamento em duas etapas para permitir que o modelo respondesse a diferentes entradas:

“Dividimos o processo em duas etapas: primeiro, gerar imagens condicionadas a um prompt de texto e, em seguida, gerar vídeo condicionado tanto ao texto quanto à imagem gerada. Essa abordagem ‘fatorada’ ou dividida para geração de vídeo nos permite treinar modelos de geração de vídeo de forma eficiente.”

O mesmo modelo pode animar imagens com base em um prompt de texto. De acordo com Meta, em vez de depender de uma cascata profunda de modelos, o Emu Video usa apenas dois modelos de difusão para gerar vídeos 512×512 de quatro segundos de duração a 16 quadros por segundo.

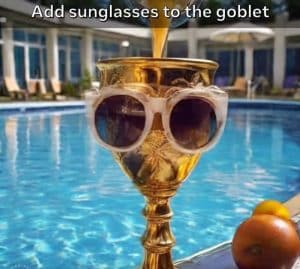

O Emu Edit, focado na manipulação de imagens, permitirá aos usuários remover ou adicionar fundos às imagens, realizar transformações de cores e geometrias, bem como edição local e global de imagens.

“Argumentamos que o objetivo principal não deveria ser apenas produzir uma imagem ‘crível’. Em vez disso, o modelo deve se concentrar em alterar com precisão apenas os pixels relevantes para a solicitação de edição. Por exemplo, ao adicionar o texto ‘Aloha!’ a um boné de beisebol, o boné em si deve permanecer inalterado.”

Meta treinou o Emu Edit usando tarefas de visão computacional com um conjunto de dados de 10 milhões de imagens sintetizadas, cada uma com uma imagem de entrada e uma descrição da tarefa, bem como a imagem de saída direcionada.

“Acreditamos que seja o maior conjunto de dados desse tipo até o momento.”

O modelo Emu recém-lançado da Meta foi treinado usando 1,1 bilhão de dados, incluindo fotos e legendas compartilhadas por usuários no Facebook e Instagram, revelou o CEO, Mark Zuckerberg, durante o evento Meta Connect.

Os reguladores estão examinando de perto as ferramentas baseadas em IA da Meta, resultando em uma abordagem de implantação cautelosa por parte da empresa de tecnologia. Recentemente, a Meta divulgou que não permitirá que campanhas políticas e anunciantes usem suas ferramentas de IA para criar anúncios no Facebook e Instagram. As regras gerais de publicidade da plataforma, no entanto, não incluem quaisquer regras que abordem especificamente a IA.